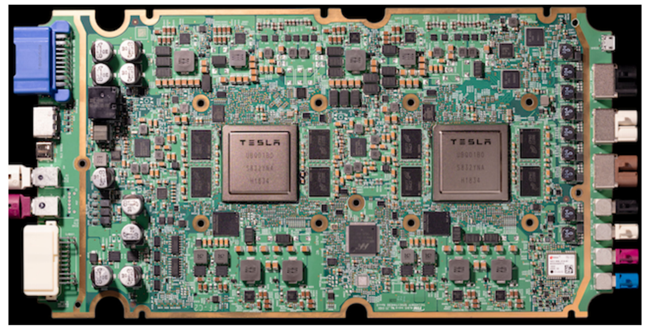

@ What is FSD? FSD (Full self-driving) is the world’s first purpose-built computer for autonomous driving SoC (System on Chip) that integrated CPUs, ISP, GPU, and Neural network accelerators Processing up to 2300 fps / 72 TOPs for neural network inference / 40W per chip Tesla’s FSD computer was designed to be retrofitted into any Tesla vehicle made since October 2016 Two instances of the FSD chi..